近日,计算与人工智能学院侯诚彬助理教授与合作团队在大语言模型(LLM)与自然语言处理领域取得重要研究进展。研究成果以“Parse Trees Guided LLM Prompt Compression”为题,发表于人工智能与模式识别领域国际顶级期刊IEEE Transactions on Pattern Analysis and Machine Intelligence(IEEE TPMAI)。

随着大语言模型(如ChatGPT、DeepSeek等)在诸多任务中表现卓越,提示词(Prompt)设计愈发重要。然而,长提示会显著增加计算成本,且可能超出模型输入长度限制,而现有提示压缩方法存在幻觉、忽略语言结构、计算效率低等问题。为此,研究团队提出了一种基于句法分析树(Parse Tree)的提示压缩方法——PartPrompt,首次将语言学规则与全局文本结构引入提示词压缩过程,在保持语义完整性、提升压缩结果的连贯性与可读性的同时大幅优化了压缩效率。

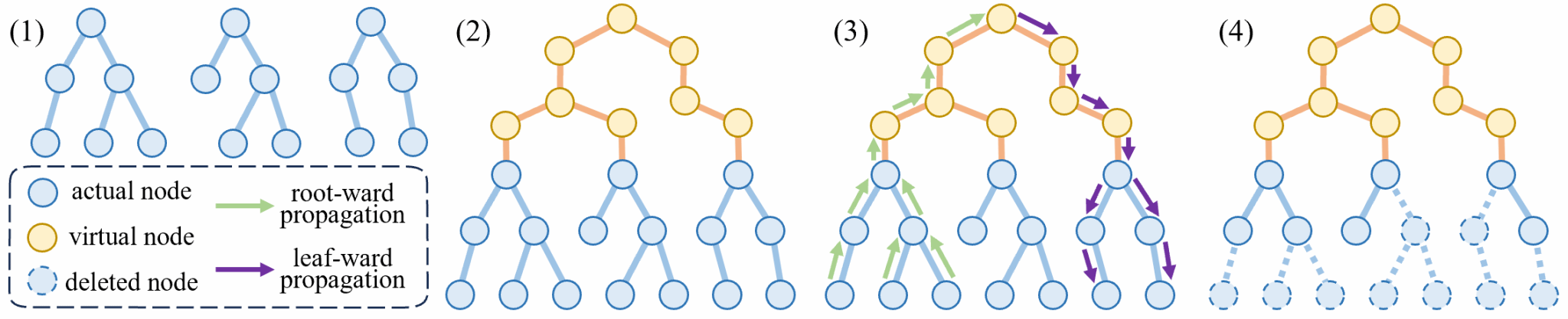

具体来说,研究团队使用句法树构建句子结构,随后提出一种名为全局层次树的新结构,根据文本特点对句子进行分析与整合,并配套设计了节点价值调整算法,以模拟人类写作逻辑。本研究使用局部信息熵近似,降低了计算复杂度。在此基础上,研究团队将提示词压缩问题转化为了树剪枝优化问题,并相应开发了一个高效算法进行问题求解。

图1:研究团队的提出的算法的整体框架

研究团队在8个不同类型的数据集(包括英文、中文、代码、长文本等)上进行了全面实验,结果表明:PartPrompt在这些情形下均优于现有主流方法(如Selective-Context, LLMLingua, LLMLingua2等);在极长提示(超过6000 tokens)场景下仍能有效压缩,而现有方法无法很好处理;压缩后的提示词在语义连贯性、结构完整性方面表现优异,显著提升下游任务(如摘要、问答、数学推理)性能;方法计算效率高,复杂度低于同类方法,更具实用价值。为了促进前沿技术发展,研究团队将收集制作的数据集连同代码一并公开。

IEEE TPAMI是中国计算机学会(CCF)推荐的人工智能领域A类期刊,也是中科院计算机科学1区TOP期刊,近五年平均影响因子20.4,长期致力于报道模式分析、机器智能、计算机视觉等领域具有重大影响力的研究成果。该研究由福耀科技大学与清华大学、南方科技大学研究人员共同完成,其中侯诚彬和闾海荣为共同通讯作者。

官网链接:https://ieeexplore.ieee.org/document/11164467

预印本:https://arxiv.org/abs/2409.15395